Mi è capitato più spesso di quanto puoi immaginare: clienti che mi dicono: “Il mio sito non si vede su Google”.

Un esempio recente: stavo finalizzando il rilascio di una nuova App (una PWA) per un cliente, mentre un altro sviluppatore lavorava a modifiche sul sito web dello stesso cliente. Dopo il lancio, ci siamo accorti che la homepage era scomparsa dalle ricerche dirette, e non parliamo di SERP competitive, ma proprio che Google non la mostrava più in nessun caso.

Appena mi è stato segnalato ho subito ispezionato il codice del sito ed ho trovato:

<meta name="robots" content="noindex">Il sito di staging (una copia del sito per fare modifiche in sicurezza) era stato sostituito a quello ufficiale, e durante il lavoro di sviluppo, era rimasto impostato in noindex. Una volta corretta l’impostazione, il sito è stato gradualmente ripristinato su Google, fino al completo recupero in poche settimane.

Questo episodio ci mostra come piccoli errori post-lancio possano bloccare completamente la visibilità di un sito, e allo stesso tempo ci insegna come trasformare ostacoli tecnici in strumenti strategici.

Indice dei contenuti

NoIndex: cosa significa e perché è importante

NoIndex è un’impostazione che dice a un bot, tipicamente quello di Google o Bing (ma Bing, serve ancora?), che una pagina non deve essere indicizzata.

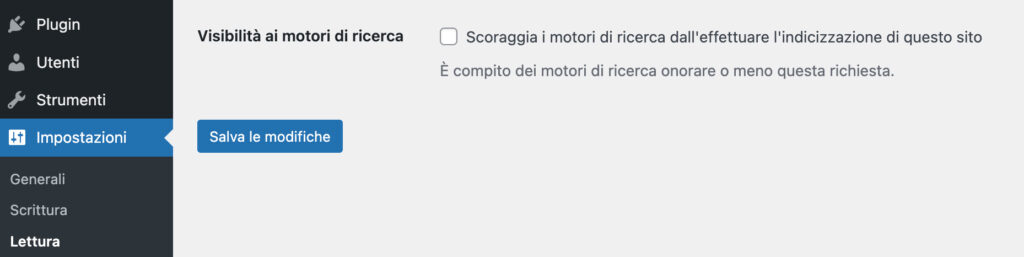

- L’impostazione può essere a livello di sito nelle impostazioni generali (Impostazioni > Lettura ).

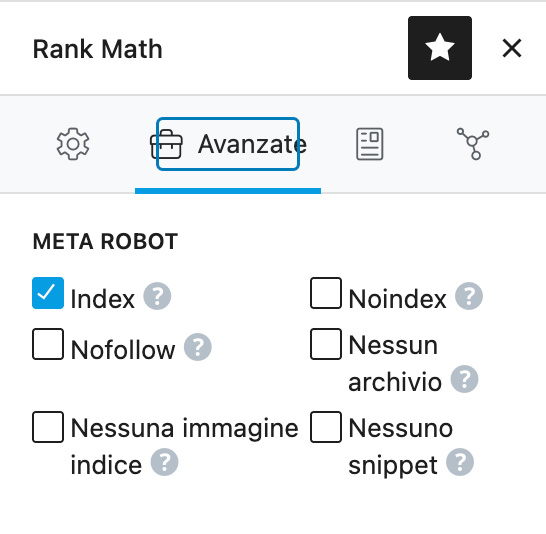

- Oppure a livello di singola pagina tramite plugin SEO, come Yoast o Rank Math.

Alcune pagine possono essere volutamente in noindex, ad esempio tag o archivi secondari, per evitare contenuti duplicati. Ma la homepage e le pagine principali devono essere in stato di index se vuoi traffico organico.

Siti visibili solo agli utenti loggati

In alcuni casi, un sito dopo lo sviluppo rimane accessibile solo agli utenti loggati con permessi da amministratore o editor.

Spesso ci si accorge del problema solo dopo il logout. Per questo è buona norma testare sempre il sito in modalità incognito o come utente non loggato.

Robots.txt: come e perché bloccare o permettere l’accesso ai bot

Robots.txt è un file tecnico, spesso autogenerato dai plugin SEO, che può bloccare l’accesso ai bot a tutto o a porzioni del sito, in base all’User-Agent.

Perché bloccare alcune pagine o cartelle?

- Durante lo sviluppo non si vuole che Google indicizzi contenuti incompleti.

- Se si crea un sito di staging, due domini con gli stessi contenuti potrebbero competere nelle SERP, rischiando di far prevalere quello meno rilevante.

- Alcune pagine vengono bloccate per evitare contenuti duplicati, come i tag, che spesso mostrano gli stessi articoli presenti nelle categorie. Bloccare queste pagine libera tempo dei bot e rende la scansione del sito più efficiente, favorendo la SEO delle pagine principali.

Strumenti che aiutano i bot a leggere il sito

Al contrario di noindex e robots.txt, alcuni file sono pensati per guidare i bot verso i contenuti importanti:

- Sitemap XML – elenca tutte le pagine indicizzabili, aiutando i bot a trovare rapidamente i contenuti principali.

- llms.txt – permette ai modelli AI generativi di comprendere la struttura del sito e valorizzare i contenuti.

Come capire se il problema è tecnico o di posizionamento

1. A volte il sito non appare su Google per problemi SEO legati ai contenuti (pagine troppo nuove, poche visite, concorrenza) e non per problemi tecnici. Per distinguerli cerca su google:

site:tuosito.com

Se non compare nessuna pagina, il problema è quasi sicuramente tecnico.

2. Una pagina nuova potrebbe non essere ancora indicizzata; in questo caso i dati in Google Search Console aiutano a capire quando è stata vista l’ultima volta dai bot.

Checklist rapida per problemi tecnici

Controlla:

- Codice del sito: meta tag robots, noindex o canonical errati.

- Impostazioni WordPress: Impostazioni > Lettura, verifica se “Scoraggia i motori di ricerca” è attivo.

- Plugin SEO: Yoast, Rank Math o altri plugin potrebbero impostare noindex su pagine chiave.

- Accesso utenti: test in modalità incognito o come visitatore esterno.

- Robots.txt: assicurati che non blocchi l’intero sito o pagine principali.

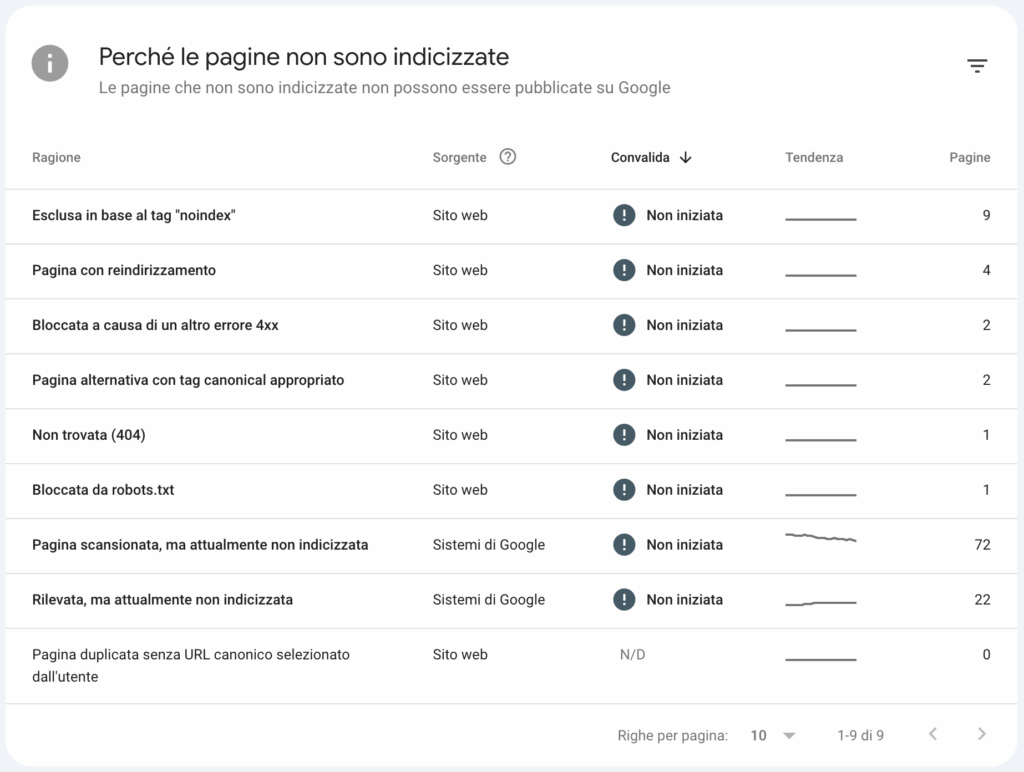

- Google Search Console: eventuali avvisi, errori di scansione o pagine escluse.

FAQ – Il tuo sito non appare su Google

1. Perché il mio sito non compare su Google?

Può essere un problema tecnico (pagine in noindex, robots.txt, sito visibile solo agli utenti loggati) o SEO (contenuti poco indicizzati o concorrenza alta).

2. Cos’è il noindex e quando usarlo?

Il noindex impedisce ai motori di ricerca di indicizzare una pagina. Serve per tag, archivi o contenuti duplicati. Homepage e pagine principali devono rimanere in index.

3. Come verificare se una pagina è in noindex?

Controlla il codice sorgente per <meta name="robots" content="noindex"> o le impostazioni nei plugin SEO come Yoast o Rank Math.

4. Perché testare il sito in modalità incognito?

Mostra cosa vedono davvero i visitatori e i bot, evitando di confondersi con il contenuto riservato agli utenti loggati.

5. Che cos’è il robots.txt e a cosa serve?

Controlla quali pagine i bot possono visitare. Bloccare contenuti duplicati o incompleti aiuta i bot a concentrarsi sulle pagine principali.

6. Cos’è una sitemap XML?

Elenca le pagine principali del sito per aiutare Google a trovarle e indicizzarle velocemente.

7. Come distinguere un problema tecnico da uno di SEO?

Cerca site:tuosito.com su Google. Se non appare nulla, è un problema tecnico; se compare ma non riceve traffico, è SEO.

8. Come Google Search Console può aiutare?

Mostra lo stato di indicizzazione, errori di scansione e problemi di accesso dei bot, aiutandoti a monitorare la salute del sito.

9. Posso risolvere subito un sito sparito da Google?

Sì, controllando subito noindex, robots.txt e visibilità del sito. Piccoli errori post-lancio possono bloccare tutto.